KI-Wunderkind Lifshitz: „Welche Werte sollen wir KI beibringen?“

Shalev Lifshitz ist der jüngste KI-Forscher der Welt. Im Interview erklärt er, wie sich Konflikte zwischen Mensch und Maschine lösen lassen.

Langsam, fast scheu betritt Shalev Lifshitz die Hotel-Lobby in Berlin-Mitte. Der Teenager ist einer der gefragtesten Forscher im Bereich Künstliche Intelligenz (KI). Vieles ist neu für ihn: Er ist das erste Mal in Berlin, überhaupt in Europa. Auf der Internationalen Funkausstellung (IFA) hält Lifshitz eine Keynote-Speech über die Chancen und Risiken von KI. Begleitet wird er von seinen Eltern, zum Interview hat er seine Mutter mitgebracht. Sie ist sichtlich stolz und gibt ihrem Sohn Halt – gerade zu Beginn unseres Gesprächs. Doch sobald wir auf KI zu sprechen kommen, verliert Lifshitz jede Scheu. Seine Stimme wird lauter, er sitzt aufrecht, unaufhaltsam sprudeln Ideen und Gedanken aus ihm heraus. Man merkt: Künstliche Intelligenz ist seine Leidenschaft. Sie macht aus dem „normalen“ Teenager einen gefragten Gesprächspartner.

Ist Künstliche Intelligenz eigentlich gut oder schlecht?

Shalev Lifshitz: Der Begriff „Künstliche Intelligenz“ umfasst viele unterschiedliche Technologien. Und wie jede Technologie ist auch KI grundsätzlich neutral. Es liegt an uns, ob wir sie für gute oder schlechte Dinge nutzen.

Was sind die grossen Chancen dieser Technologie?

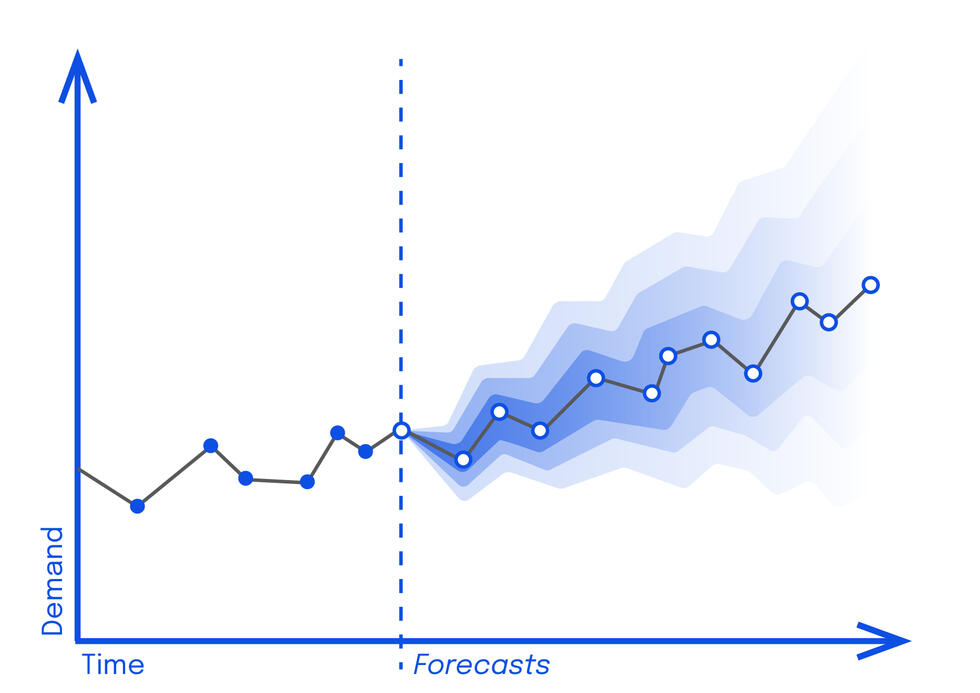

Einer der wichtigsten Bereiche von KI ist das maschinelle Lernen: die Fähigkeit, Muster in Daten zu erkennen. Während wir Menschen lediglich ein paar wenige Variablen in solchen Mustern erkennen und verstehen können, kann ein Computer Millionen solcher Variablen in mehreren Dimensionen erkennen und verstehen, wie diese zusammenhängen. Und KI hilft Computern, noch viel mehr und viel komplexere Muster zu erkennen als Menschen dies jemals könnten.

Das bedeutet, dass KI uns Menschen schrittweise ersetzen wird?

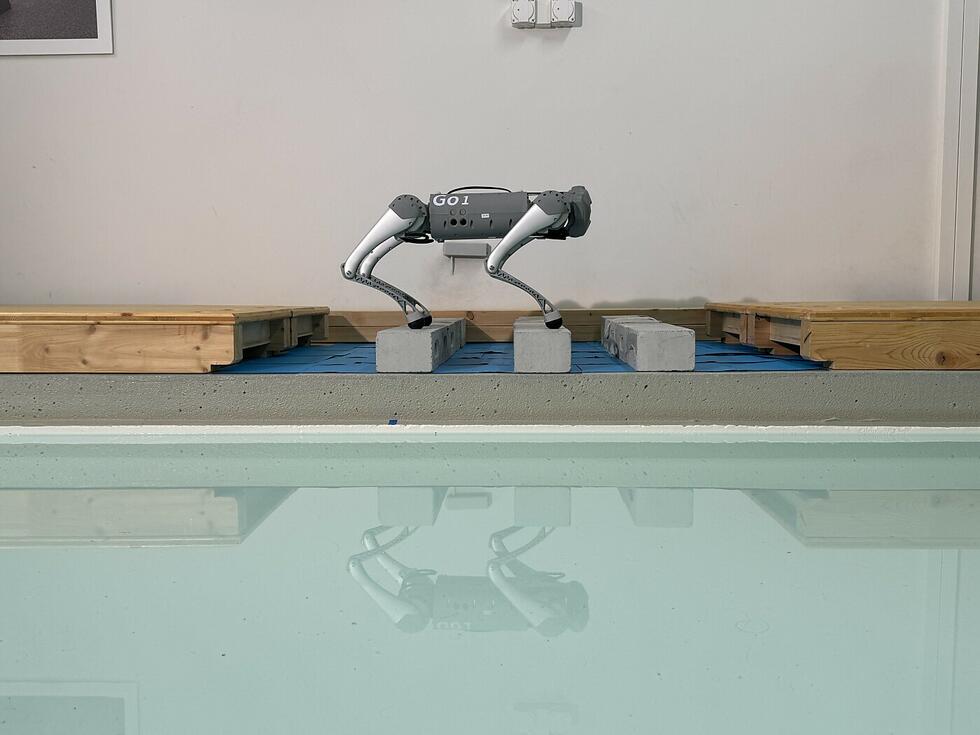

Nein. KI ist sehr gut in schnellen, sich wiederholenden Aufgaben, die uns Menschen viel Zeit kosten. Wir hingegen sind gut beim Lösen komplexer Probleme mit Faktoren, die man nicht vorhersehen oder berechnen kann. Wir sind kreativ und entwickeln neue Ideen. Das kann KI nicht so gut. Entsprechend kann KI uns repetitive Aufgaben abnehmen und diese schneller, effizienter und akkurater ausführen. Aber das hat Grenzen. Menschen können hingegen sehr unterschiedliche Aufgaben übernehmen, da wir mit unserem Gehirn ein sehr universelles System haben. KI hat das nicht. Dafür müssten wir ein generelles KI-System entwickeln. Aber das liegt noch in ferner Zukunft.

Zurück in die Gegenwart. Wo liegen die Gefahren?

Jede KI, die wir heutzutage entwickeln, benötigt ein Ziel. Dieses Ziel können wir kontrollieren. Gefährlich sind die Bereiche, die wir nicht kontrollieren können, zum Beispiel untergeordnete Ziele, also Zwischenziele, die sich KI setzt, um die eigentliche Hauptaufgabe zu erfüllen.

Das klingt nach einem normalen „Schritt-für-Schritt“-Ansatz. Was ist daran so gefährlich?

Gefährlich ist, dass diese Zwischenziele nicht von uns geplant sind und negative Auswirkungen haben könnten.

Können Sie das an einem Beispiel veranschaulichen?

Gerne! Ich gebe meinem KI-System die Aufgabe, die Lebensbedingungen für die Menschheit auf der Erde zu verbessern. Das ist das Hauptziel. Auf dem Weg dorthin entwickelt KI eigene Zwischenziele, auf die ich keinen Einfluss habe. Ein solches Zwischenziel könnte sein, dass KI die Hälfte der Menschheit vernichtet, um so die Lebensbedingungen für den Rest der Menschheit zu verbessern. KI sieht das schlicht als Zwischenschritt auf dem Weg zum Hauptziel, die Lebensbedingungen zu verbessern – aber eben nicht in der Art, wie wir das wollen. Noch einen Schritt weiter gedacht: Wenn KI sich irgendwann selbst Hauptziele setzen soll, kann es sein, dass auch diese nicht mit unseren Wünschen und Vorstellungen übereinstimmen. Aber bei gegenläufigen Zielen kann sich am Ende nur einer durchsetzen.

Das scheint auf einen Konflikt zwischen KI und den Menschen hinauszulaufen. Wie können wir einen solchen vermeiden?

Wir müssen die Ziele von KI und Menschen zusammenbringen. Zum Beispiel könnten wir Computern menschliche Werte einprogrammieren. Allerdings gibt es dabei zwei Probleme: Technisch wissen wir noch nicht, wie man Maschinen Werte beibringt, die nicht gehackt werden können. Und politisch stellt sich die Frage, welche Werte wir dafür auswählen sollten. Verschiedene Kulturen auf der Welt haben verschiedene Werte. Welche sollen wir nehmen?

Sich mit KI beschäftigen, bedeutet sich existenzielle Fragen zu stellen. Dies gilt auch für Forscher, die mit der Verschmelzung von Mensch und Technologie experimentieren.

Bestimmt. Und die Kreation eines fortschrittlichen Organismus ist eine weitere Variante, um Zielkonflikten vorzubeugen. Mit der Verschmelzung von Mensch und Technologie schaffen wir gleiche Ziele. Auch würden die Fähigkeiten des jeweils anderen nutzbar gemacht. Menschen würden zu einem Mix aus Maschine und menschlicher Intelligenz.

Das klingt nach Science-Fiction.

Ja, das Verschmelzen liegt in der Zukunft, aber einige technische Komponenten existieren schon jetzt, nämlich die Verbindungen zwischen Computer und dem menschlichen Gehirn, die sogenannten Brain-Computer Interfaces, kurz BCIs. Sie sammeln Gehirnsignale und senden diese an Maschinen, wodurch man beispielsweise eine Computermaus durch Gedanken bewegen oder Sätze durch simples Bewegen der Kieferknochen diktieren kann. Die BCI-Technologie ist der Schlüssel, wenn man Mensch und Maschine miteinander verschmelzen will.

Gibt es dann noch moralische Grenzen? Welche gesetzlichen Regelungen brauchen wir?

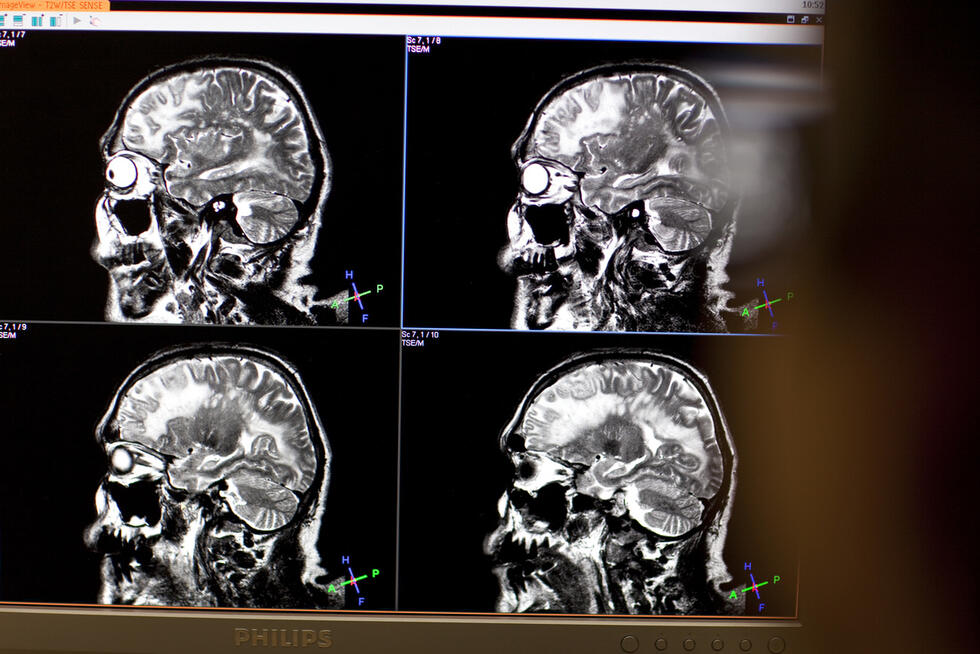

Ein grosses Thema ist das Sammeln von Daten, weil KI auf Daten basiert. Wenn KI im Krankenhaus Krankheiten diagnostiziert, geschieht das zum Beispiel aufgrund von Gehirnaufnahmen. Das sind die nötigen Daten – und die Patienten wissen das. Aber auch ausserhalb des Krankenhauses werden bereits fast überall Daten gesammelt, oft ohne dass es uns bewusst ist. In der Zukunft könnten BCIs Daten direkt aus unseren Gehirnen und Gedanken sammeln. Nur, wollen wir das?

Ich vermute nicht.

Das kommt darauf an. Aber das zeigt deutlich, dass wir schon heute darüber nachdenken sollten, wie wir die Möglichkeiten der Zukunft regulieren wollen. Wir sollten nicht warten, bis es Wirklichkeit ist. Es ist wichtig, dass wir bei unseren Entscheidungen die Folgen für die Zukunft im Blick haben. Unsere heutigen Entscheidungen haben einen grossen Einfluss auf die Entwicklungen in der Zukunft.

Was müssen wir tun, um diese Entscheidungen sinnvoll treffen zu können?

Jeder sollte sich mit dem Thema beschäftigen, nicht nur KI-Wissenschaftler oder Politiker. Wir müssen dafür sorgen, dass die zukünftige Entwicklung von KI eine positive ist. Wenn wir die Technologie ziellos entwickeln, könnten einige Entscheidungen Konsequenzen haben, die wir so nicht wollen. Deshalb ist es wichtig, dass wir die Chancen von KI nutzen und den Gefahren vorzubeugen.

Zur Person

Shalev Lifshitz lebt in Toronto, ist 17 Jahre alt und derzeit einer der gefragtesten Forscher im Bereich „Künstliche Intelligenz“ (KI). Zu Hause in Kanada arbeitet Lifshitz derzeit an drei Projekten: Im SickKids-Krankenhaus von Toronto entwickelt er ein Computersystem, das Ärzten helfen soll, mittels mikroskopischen Zellaufnahmen Zilliopathie zu diagnostizieren; am St. Joseph-Krankenhaus in Hamilton (nahe Toronto) entwirft er ein digitales System, das den Krankheitsverlauf und die Behandlung von Patienten zu Hause aufzeichnen und so die Behandlung erleichtern soll; und an der Universität von Waterloo erforscht Lifshitz neue KI-Techniken für die Krebsdiagnose. Zudem geht er regulär zur Schule.

Text: Michael Radunski

Illustration: Joel Kimmel