KURZMELDUNG

Schweizer Forscher entschlüsseln Denkprozesse von KI

Forschende haben eine neue Methode zur Entschlüsselung des Denkens von Künstlichen Intelligenzen entwickelt. Dies ist besonders wichtig für Situationen, in denen selbstlernende Computerprogramme Entscheidungen mit Auswirkungen auf Menschenleben treffen.

«Die Funktionsweise dieser Algorithmen ist, gelinde gesagt, undurchsichtig», sagte Studienleiter Christian Lovis von der Universität Genf (Unige) in einer Mitteilung. «Wie können wir einer Maschine vertrauen, ohne die Grundlage ihres Denkens zu verstehen?» Deshalb hat ein internationales Forschungsteam unter der Leitung der Universität Genf genau das untersucht.

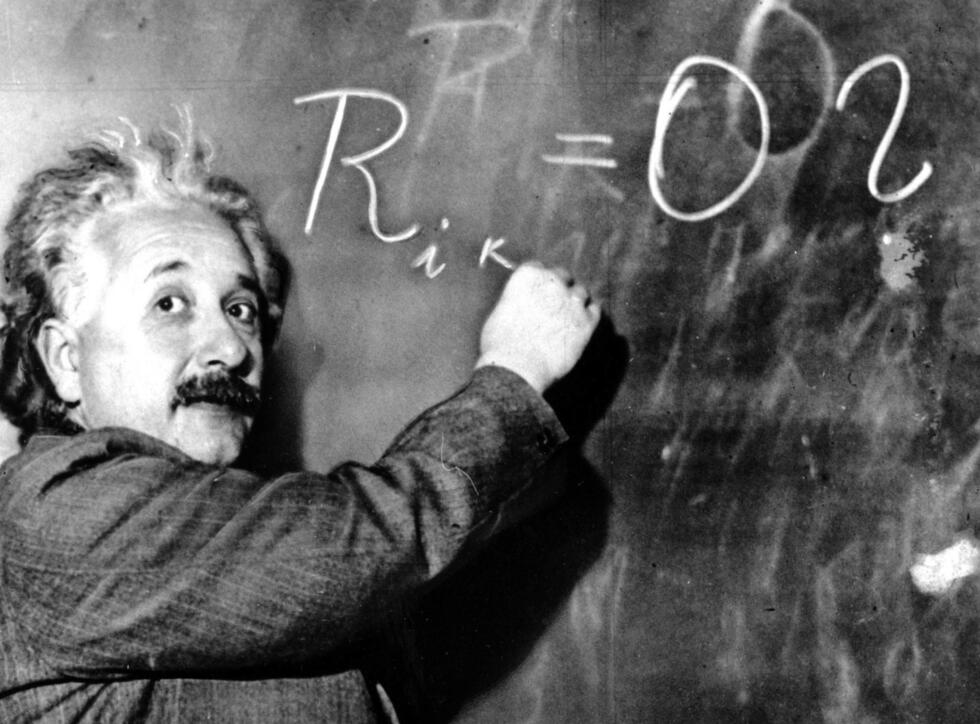

Künstliche Intelligenzen (KI) werden mit grossen Datenmengen trainiert. Wie bei einem Kleinkind, das seine Muttersprache lernt, ohne sich den Grammatikregeln bewusst zu sein, können die KI-Algorithmen durch das selbstständige Abgleichen vieler Eingabedaten lernen, die richtige Auswahl zu treffen.

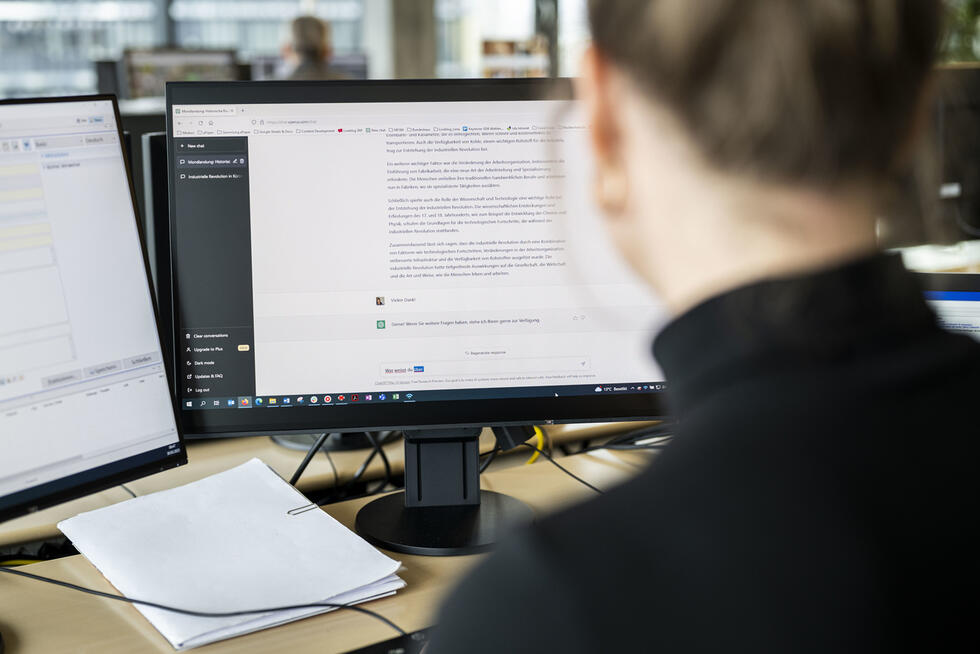

Wie die Algorithmen dieser selbstlernenden Computer ihre Eingabedaten intern darstellen und verarbeiten, ist jedoch eine «Black Box». Um diese zu erhellen, gibt es sogenannte Interpretationsmethoden. Sie zeigen, welche Daten und Faktoren für die Entscheidungen der KI ausschlaggebend sind.

Welcher Ansatz stimmt?

In den letzten Jahren wurden verschiedene solche Methoden entwickelt. Diese Interpretierbarkeitsmethoden führen jedoch oft zu unterschiedlichen Ergebnissen, was die Frage aufwirft, welcher Ansatz der richtige ist. Die Auswahl eines Interpretierbarkeitsansatzes aus der Vielzahl der verfügbaren Ansätze für einen bestimmten Zweck kann daher schwierig sein, wie in der Studie festgestellt wird.

Die von Forschenden der Universität Genf, des Universitätsspitals Genf (HUG) und der National University of Singapore (NUS) entwickelte neue Methode kann die Zuverlässigkeit verschiedener solcher Methoden testen. Die Ergebnisse wurden kürzlich in der Fachzeitschrift «Nature Machine Intelligence» veröffentlicht.